Syniti DR(旧DBMoto)を使用してMySQLへレプリケーションを実施したときに、次のエラーが発生することがあります。

MySql.Data.MySqlClient.MySqlException (0x80004005): Loading local data is disabled; this must be enabled on both the client and server sides

続きを読むSyniti DR(旧DBMoto)を使用してMySQLへレプリケーションを実施したときに、次のエラーが発生することがあります。

MySql.Data.MySqlClient.MySqlException (0x80004005): Loading local data is disabled; this must be enabled on both the client and server sides

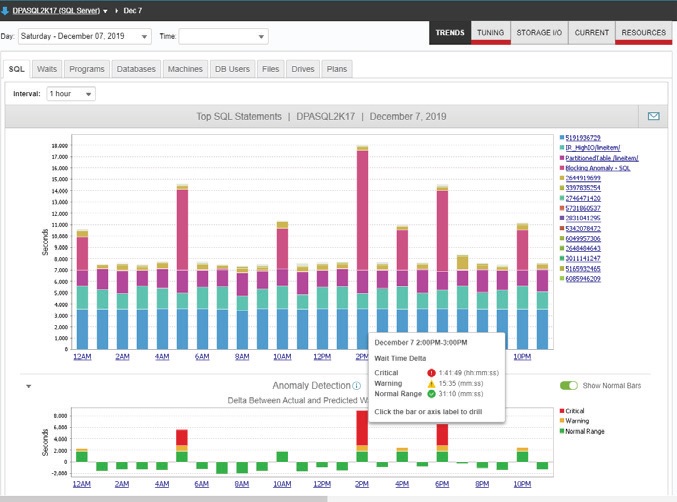

続きを読む Database Performance Analyzer(DPA)は、10以上の主要なデータベース・プラットフォームをサポートしており、データベース管理者(DBA)は、通常数秒から数分でパフォーマンス問題の根本原因を突き止めることができます。すべてのクエリには異なる応答時間があり、ボリュームの多い営業時間帯と少ない営業時間帯では異なります。機械学習による異常検知により、DPAは従来のパフォーマンス監視製品とは一線を画しています。クエリやインデックスのチューニングに加え、DPAによる待機ベースの分析により、CPUやストレージのリソース消費によるVMの遅延など、クエリが遅くなる原因を特定することができます。DPAは、実際の作業負荷に基づいて最適化の機会を特定することで、チューニングをリアクティブからプロアクティブに変えます。

Database Performance Analyzer(DPA)は、10以上の主要なデータベース・プラットフォームをサポートしており、データベース管理者(DBA)は、通常数秒から数分でパフォーマンス問題の根本原因を突き止めることができます。すべてのクエリには異なる応答時間があり、ボリュームの多い営業時間帯と少ない営業時間帯では異なります。機械学習による異常検知により、DPAは従来のパフォーマンス監視製品とは一線を画しています。クエリやインデックスのチューニングに加え、DPAによる待機ベースの分析により、CPUやストレージのリソース消費によるVMの遅延など、クエリが遅くなる原因を特定することができます。DPAは、実際の作業負荷に基づいて最適化の機会を特定することで、チューニングをリアクティブからプロアクティブに変えます。

使用するアプリケーションの仕様などにより下記のように、各カラムの名前を値として持つように転置した状態のテーブルへのレプリケーションを構成するような場合、Syniti DRでは対象となるカラム数分のレプリケーションを作成する必要が有ります。

続きを読むSyniti DRではOracle DBをソースとして変更追跡する際に、トランザクションログ方式、ログサーバエージェント方式、トリガー方式から選択可能ですが、このうち、トランザクションログ方式とログサーバーエージェント方式ではOracleのRedoログを利用します。

続きを読むSyniti DRは異種データベース間でのレプリケーションを提供するソリューションであり、データ連携や移行、保護など様々な用途でご利用いただいています。

続きを読むSyniti DR 9.8で追加されたリフレッシュ処理のパーティション機能を使用すると、リフレッシュ(全件転送)時の分割処理を構成でき、複数の並列スレッドがデータを処理するため、パフォーマンスを向上できます。

続きを読む昨今、データ活用が注目され、企業が保有しているデータを分析用のプラットフォームへ移動する需要が増えています。

このようなデータプラットフォームに対して、Syniti Data Replication(以下Syniti)を利用することで、あらゆるRDBMSからDWHなどのデータプラットフォームへ開発を行うことなく手軽にデータ連携が可能です。

※Synitiがサポートしているデータベースについては、こちらをご覧ください。

Heroku は簡単にアプリケーションの開発から実行、運用までのすべてをクラウドで完結できる PaaSです。このHeroku が使用しているデータベースである Heroku Postgres とオンプレミスの異種データベースとのデータの連携を簡単に行いたいという声をよく聞きます。

続きを読む〇HerokuはSalesforceの子会社で、アプリケーシ

続きを読む