あるベテランVMware管理者からの推奨:

毎日のVMwareメンテナンス・タスク:

●アラーム用のメールボックスの確認

一旦適切なアラームが構成されれば、その後は多くの努力を必要としません。

●サーバ・ルームへ足を運ぶ

アラームを設定していても、ホストのコンポーネント表示を実際に確認する方が正確に見分けることができます。

あるベテランVMware管理者からの推奨:

毎日のVMwareメンテナンス・タスク:

●アラーム用のメールボックスの確認

一旦適切なアラームが構成されれば、その後は多くの努力を必要としません。

●サーバ・ルームへ足を運ぶ

アラームを設定していても、ホストのコンポーネント表示を実際に確認する方が正確に見分けることができます。

●高可用性

VMwareの高可用性を実現するには、VMwareHA(以下HA)とFTがあります。

HA・・・故障時のリカバリ方法は、仮想マシンをパワーオンからやり直すというものです。そのため、サービスが回復するまでには一定の時間を要します。

FT・・・仮想マシンの実行はそのまま継続されるため、メモリ上のデータも含めデータロスは発生しません。

多くのユーザはディスクIOPS(input/output operations per second)の大容量を生成可能な 仮想マシン(VM)用シック仮想ディスクで困っています。(調査ではシックのパフォーマンスで利点は名ばかりであると指摘していますが。)しかしユーザはほとんどディスクIOPSを生成しないサーバ・ベースのVM上でシン仮想ディスクを使用しています。

Veeam Availability Suit v10の一部であるVeeam Continuous Data Protectionは、VAIO (vSphere APIs for I/O)フィルタリングを使用してスナップショットに関連する問題を回避し、RPOとRTOを削減します。

Veeam Availability Suit V10にはVeeam Continuous Data Protectionが含まれています。

Veeam Continuous Data Protectionは、リカバリポイントを短縮することが目的のスナップショットレスレプリケーションメカニズムです。

インストールが完了すると、管理者はESXiの時刻同期を最優先に設定する必要があります。

設定しない場合、アプリケーションの障害、VMの問題などが発生する可能性があります。

ESXiの時刻同期設定がオフの場合、VM、アプリケーション、およびファイルサーバに問題が発生する可能性があります。ESXi 6.5のインストール後、管理者にとって最も重要なことの1つは、時間同期を設定することです。

VMware Storage I/O controlは、vSphere のストレージ品質を向上させるのに役立ちます。

vSphere 6.5はStorage I/O control機能をVMストレージポリシーに統合します。

仮想化は企業に多大な利益をもたらしますが、仮想マシンのI/O要求は問題になる可能性があります。すべてのVMはあるレベルのストレージトラフィックを発生させ、その結果生じる1秒当たりのI/O 操作は競合を招き、重要なワークロードのパフォーマンスを低下させる可能性があります。

Storage I/O Controlは共有ストレージの問題を処理する有効な方法ですが、全ての仮想マシンに必ずしも適しているわけではありません。

Storage I/O Controlは、ストレージレイテンシを使用して、データセンター内の仮想マシンに提供されるI/Oキュー共有を管理します。Storage latencyが増加(悪化)し、定義したしきい値を超えると、I/Oシェアが減少し、VMのストレージ使用量が減少します。これにより、負荷の低い他VMのStorage I/O Control 帯域幅がさらに広がり、データセンターに問題が発生します。

VMwareセキュリティ違反は軽く取り扱われるべきではありません。特に法令順守が注目されて、さらにクラウド・コンピューティングに向かっている現状では。

仮想ホストは多くのワークロードを背負い、悪質な人間がホストに対して許可のないアクセスを行ったなら、その人間はすべての仮想マシン(VM)を危険にさらす可能性があります。そこで仮想管理者はVMwareセキュリティ違反を防ぐために特別な注意が必要になります。VMwareセキュリティ違反が起きる可能性のあるいくつかの弱点があります。

ReFS (Resilient File System)はWindows Server 2012で紹介されたストレージ技術で、それ以降に新機能や改善が追加されています。Hyper-V VMホスト用としてNTFSからReFSに移行するには納得する理由が必要とするでしょう。

Hyper-VでReFSを使用することで即にスピードと効率化の2つを得ることができます。最初の方はVMチェック・ポイントはメタデータ・アップデートで行われ、Hyper-V 2016内のディスクでは非常に高速で、これは「Production Checkpoint」と呼ばれます。2番目は固定サイズのVHDやVHDXファイルをプロビジョンしたときに即に有益で、ReFSはユーザに利益をもたらします。あるMicrosoft MVPのテストではNTFSでの500 GB VHDXファイルのプロビジョニングで2441秒(約40分)係ったものが同じサイズでReFSでは13秒というレポートもあります。Hyper-V 2016でこの機能はInstant Fixed Disk Creationとして知られています。このWindows Server 2016での2つのブランドはユーザに大きな利益をもたらします。

2016年11月28日~12月2日までの5日間にアメリカのラスベガスで開催された「AWS re:Invent」に弊社社員が参加しました! 2016年12月8日に開催しましたクライム・クラウド・カンパニー 感謝祭2016での AWS re:Invent 2016 報告です。

AWS Re:Inventも最終日でRe:Playパーティなどもありましたが、ブログの方では引き続きセッションの情報を展開していきます。

DAT308: Fireside chat with Groupon, Intuit, and LifeLock on solving Big Data database challenges with Redis

オープンソースのNoSQLなインメモリデータベースプラットフォームRedisの事例紹介セッションでした。以下のユーザが実際にRedisの使い勝手や気に入ってる点などを紹介してました。

本日もラスベガスで行われているAWS Re:Invent 2016の情報を展開させていただきます。

・MBL306:Serverless Authentication and Authorization: Identity Management for Serverless Architectures

AWSでサーバレスアーキテクチャを実現する際の認証に焦点を当てたセッションでした。AWS Cognitoの認証を使用し、SRP(セキュアリモートパスワード)プロトコルとJWT(JSON WEB トークン)を使用した安全な認証を行い、S3などのAWS上のリソースにアクセスし、サーバーレスで簡単にアイデンティティ管理が行えるというものです。このセッションでは実際にどのように認証されるのか、IAMとの連携やSMALとの統合などを紹介するたびに、サンプルのアプリからのアクセスを行った場合のデモを交えて紹介していました。

基調講演は多くの方が展開していると思いますので、本ブログではRe:invent 2016で受講した各Breakoutセッションを紹介していきます。Re:inventでは500以上のセッションがあるので、ここで紹介させていただけるのは、ほんの一部ですが雰囲気だけでも感じていただければ幸いです。

・ENT212:Preparing for a Large-Scale Migration to AWS

前回はAWSからローカル間の通信で躓いたポイントを紹介しました。

今回は環境構築後に躓いたポイントと解決策をご紹介します。

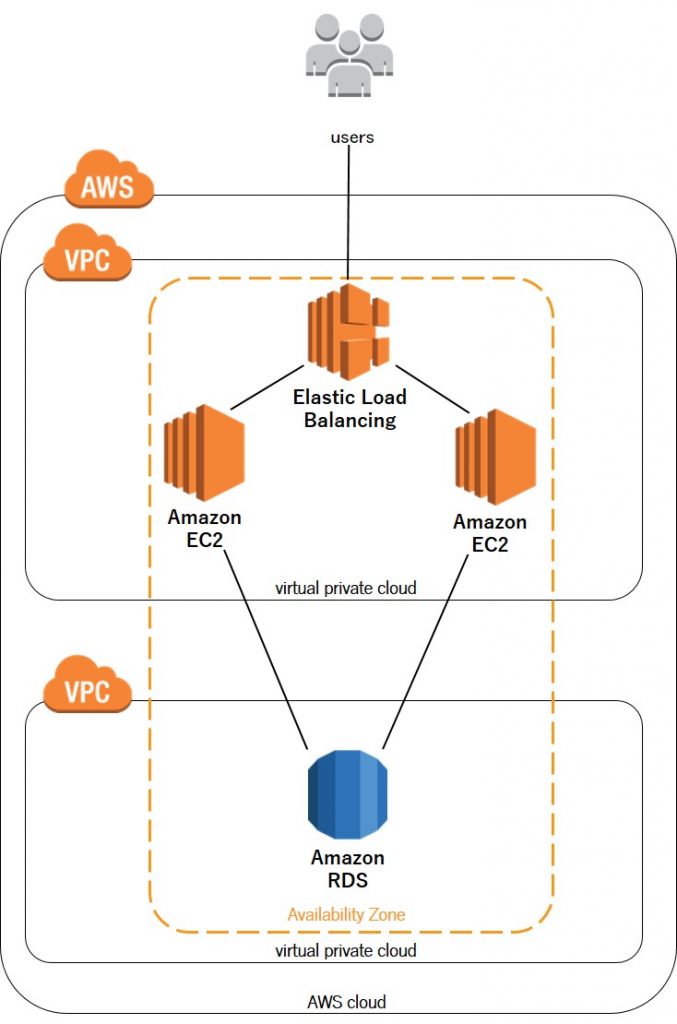

以下がイメージ図となります。

簡単なシステムの流れは、外からのアクセスをELBで別々のEC2インスタンスに分散させ、

各EC2インスタンスから単一のRDSへデータの書き込みや読み込みを行います。

ページにアクセスした際、別のEC2インスタンスに自動的に切り替えて負荷分散するようなイメージです。

各EC2でOSを立ち上げ、VPCのセキュリティグループも何とか設定、RDSとも無事接続し

今回の肝であるELBを各EC2インスタンスに接続して、Health Checkも完了

あとはアクセスして動作確認をするだけ!