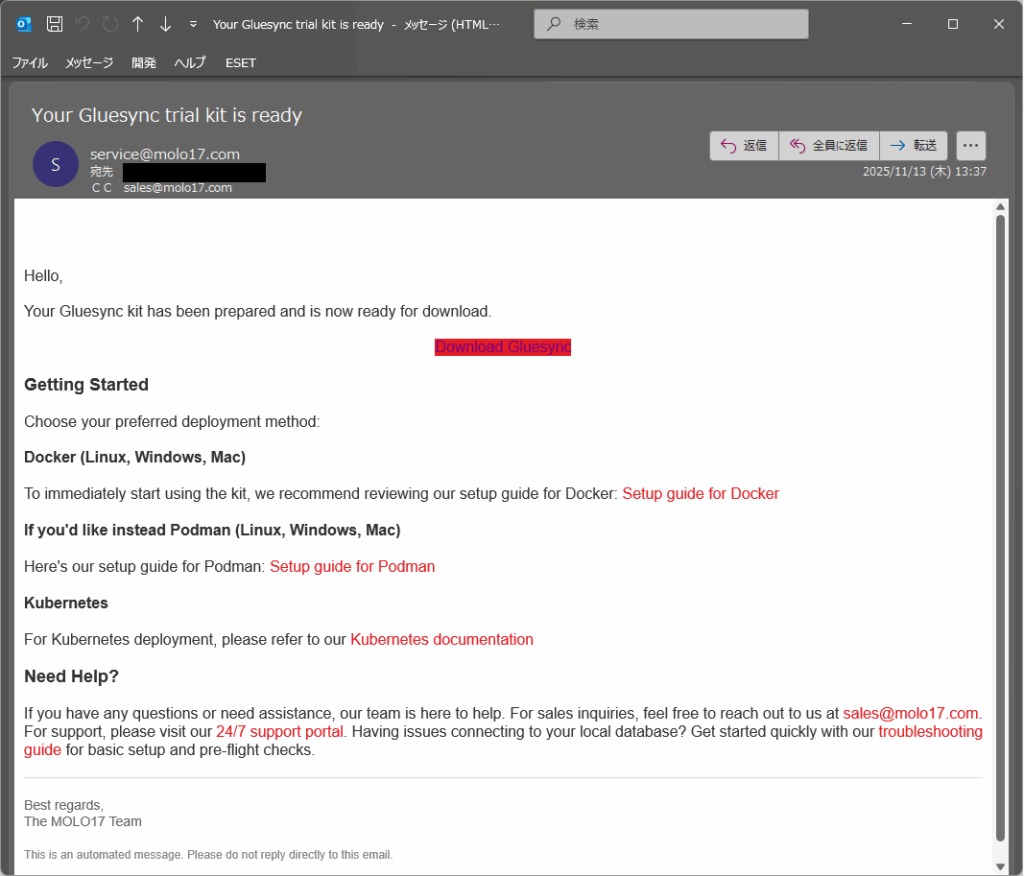

Gluesyncの評価を申請すると下記の様なメールが届きます。Download Gluesyncのリンクを開きます。

データベース移行や連携を進める上で、負担になりがちな作業の一つにターゲットテーブルの用意が挙げられます。

続きを読む既存のデータベース上にあるデータをクラウド上で分析する際に、コネクタなどで直接参照するといった方法もありますが、セキュリティなどの観点から直接の参照はむずかしい、データをマスクやフィルタリングする必要があるなど、手間がかかります。

続きを読むDatabase Performance Analyzer (DPA) 2025.3の一般提供(GA)リリースは主にメンテナンスリリースですが、いくつかの新機能も含まれています。詳細は以下をご覧ください。

続きを読む 今日の急速に変化するデジタル環境において、データベース管理者はかつてないレベルの複雑さに直面しています。最も差し迫った4つのデータベース課題に焦点を当て、堅牢なデータベース可視・観測性が運用をどのように変革できるかを探りましょう。

今日の急速に変化するデジタル環境において、データベース管理者はかつてないレベルの複雑さに直面しています。最も差し迫った4つのデータベース課題に焦点を当て、堅牢なデータベース可視・観測性が運用をどのように変革できるかを探りましょう。

先日リリースされたGluesync 2.1.1にて、「Allowed Operation」と呼ばれる機能が追加されました。